免费无限调用! GLM-4.7 + MiniMax M2.1 API,国内直连零门槛Claude Code 配置教程

昨晚刷个好东西:NVIDIA NIM 居然把 GLM-4.7 和 MiniMax M2.1 都加进去了,而且是免费的。

我第一反应是不信。毕竟这两个模型刚发布没多久,GLM-4.7 在编程圈子里已经被吹上天了,MiniMax M2.1 更是号称多语言编程能力吊打一众闭源模型。这么好的东西,NVIDIA 说送就送?

试了一下,还真能用。那这就可以成为Claude和GPT模型的国内替代品啦!

先说结论

NVIDIA NIM 现在免费提供这两个模型的 API 调用:

| 模型 | 模型名称 | 特点 |

|---|---|---|

| GLM-4.7 | z-ai/glm4.7 |

智谱最新旗舰,编程能力炸裂,前端审美在线 |

| MiniMax M2.1 | minimaxai/minimax-m2.1 |

多语言编程王者,Agent 任务稳如老狗 |

API 地址统一是:https://integrate.api.nvidia.com/v1

不过有个小问题:这两个模型目前还没在官方模型广场页面列出来,但 API 实测已经可以调用了。估计是刚上线,资源还比较紧张。

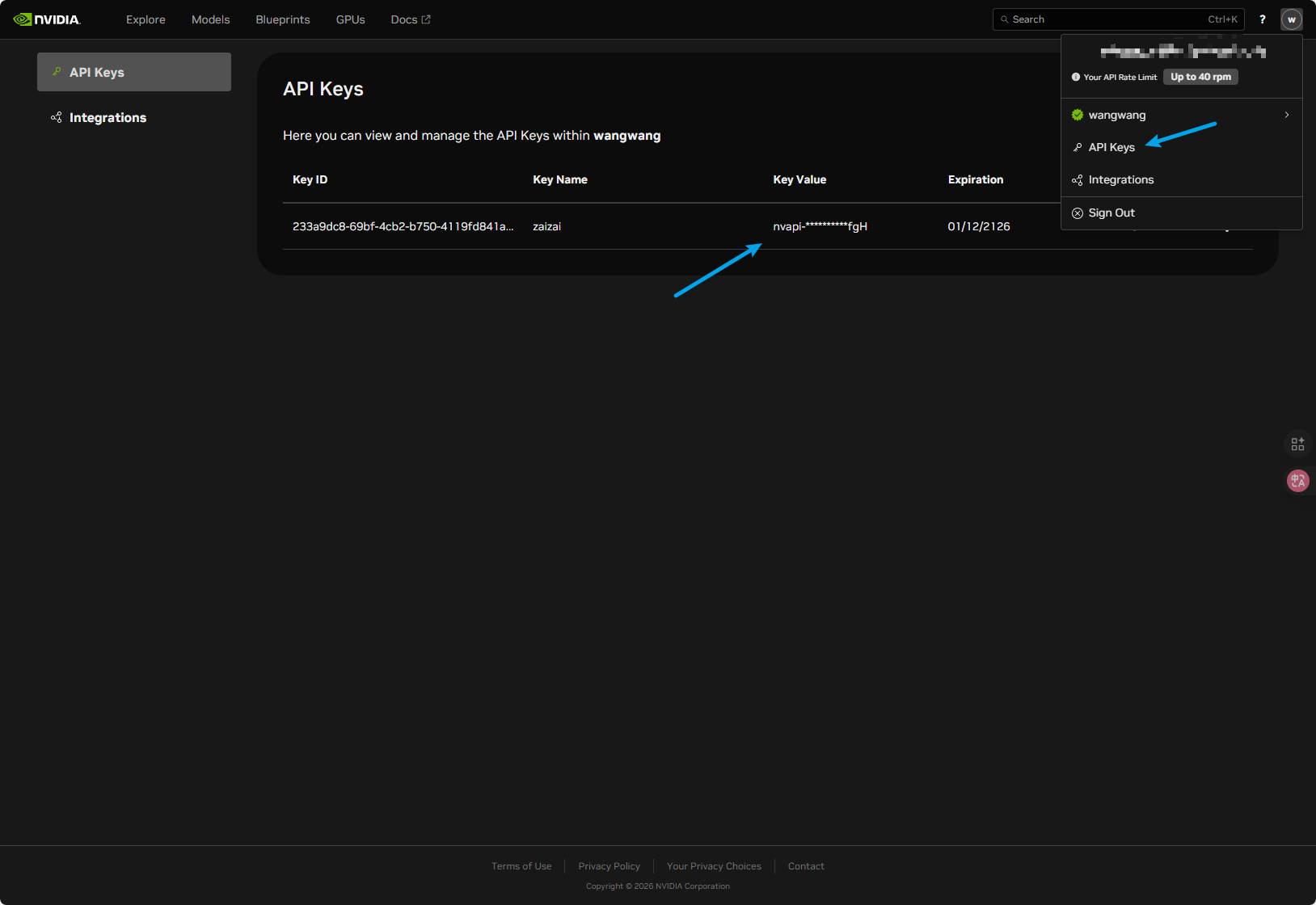

怎么获取 API Key?

这是最简单的一步:

- 打开 build.nvidia.com

- 注册/登录 NVIDIA 账号

- 进入 Settings → API Keys

- 点击生成新的 API Key

搞定。新用户还会送一些免费额度,日常开发测试绰绰有余。

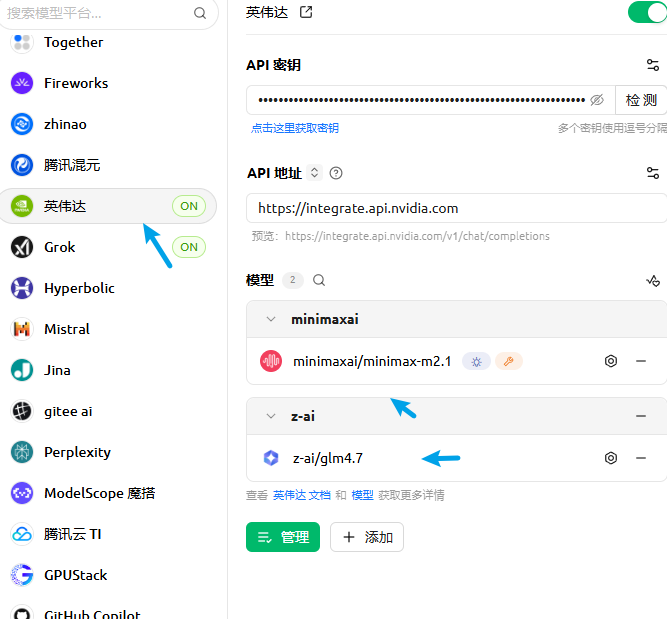

在 Cherry Studio 中配置

Cherry Studio 支持添加自定义服务商,配置起来很简单。

步骤 1:添加自定义服务商

- 打开 Cherry Studio,点击左侧「设置」(齿轮图标)

- 选择「模型服务」选项卡

- 点击「+ 添加」按钮

- 填写信息:

- 提供商类型:选择 英伟达

步骤 2:配置 API

找到刚添加的服务商,配置以下信息:

- API 密钥:填入你在 NVIDIA 获取的 API Key

步骤 3:添加模型

点击「管理」按钮,手动添加这两个模型:

z-ai/glm4.7 |

打开右上角的启用开关,就可以在对话中选择这两个模型了。

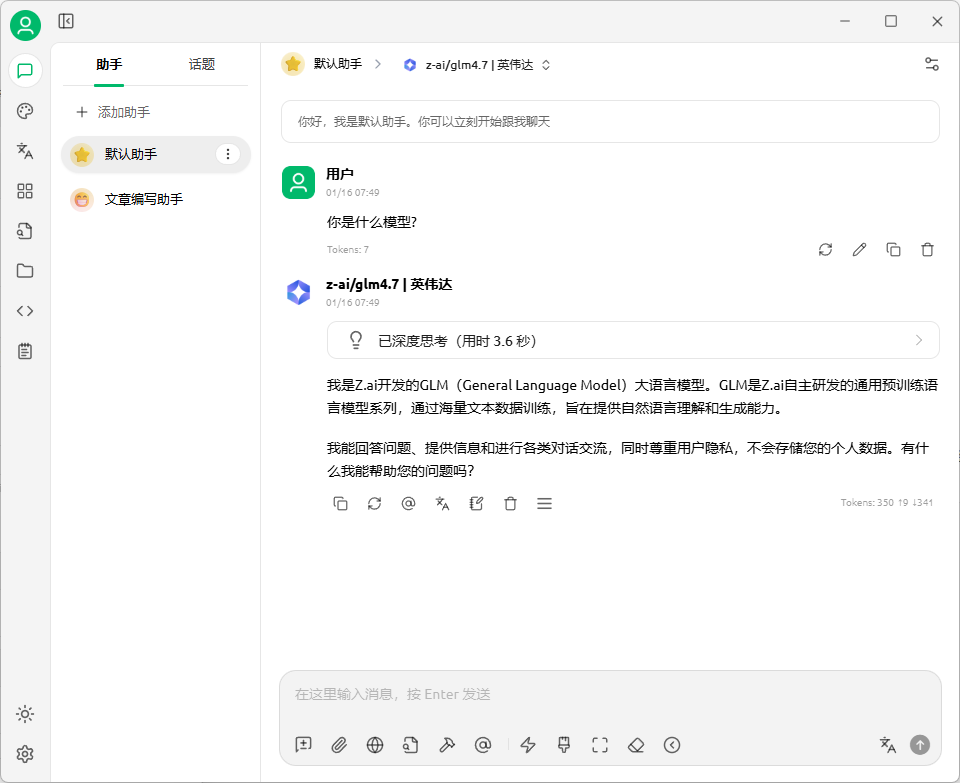

在 Claude Code 中配置

Claude Code 默认用的是 Anthropic 官方 API,但它支持 OpenAI 兼容接口,所以可以配置第三方模型。

踩坑提醒:NVIDIA NIM 的接口是 OpenAI 兼容格式,不是 Anthropic 格式。别填错环境变量名了,我第一次就搞混了,折腾了半小时才发现。

这里推荐使用一些开源项目集中配置API,方便小白,比如Claude Code Switch 或者 Claude Code Router(https://github.com/musistudio/claude-code-router) ,我前几天的文章还分享过其他的,可以去看一看!

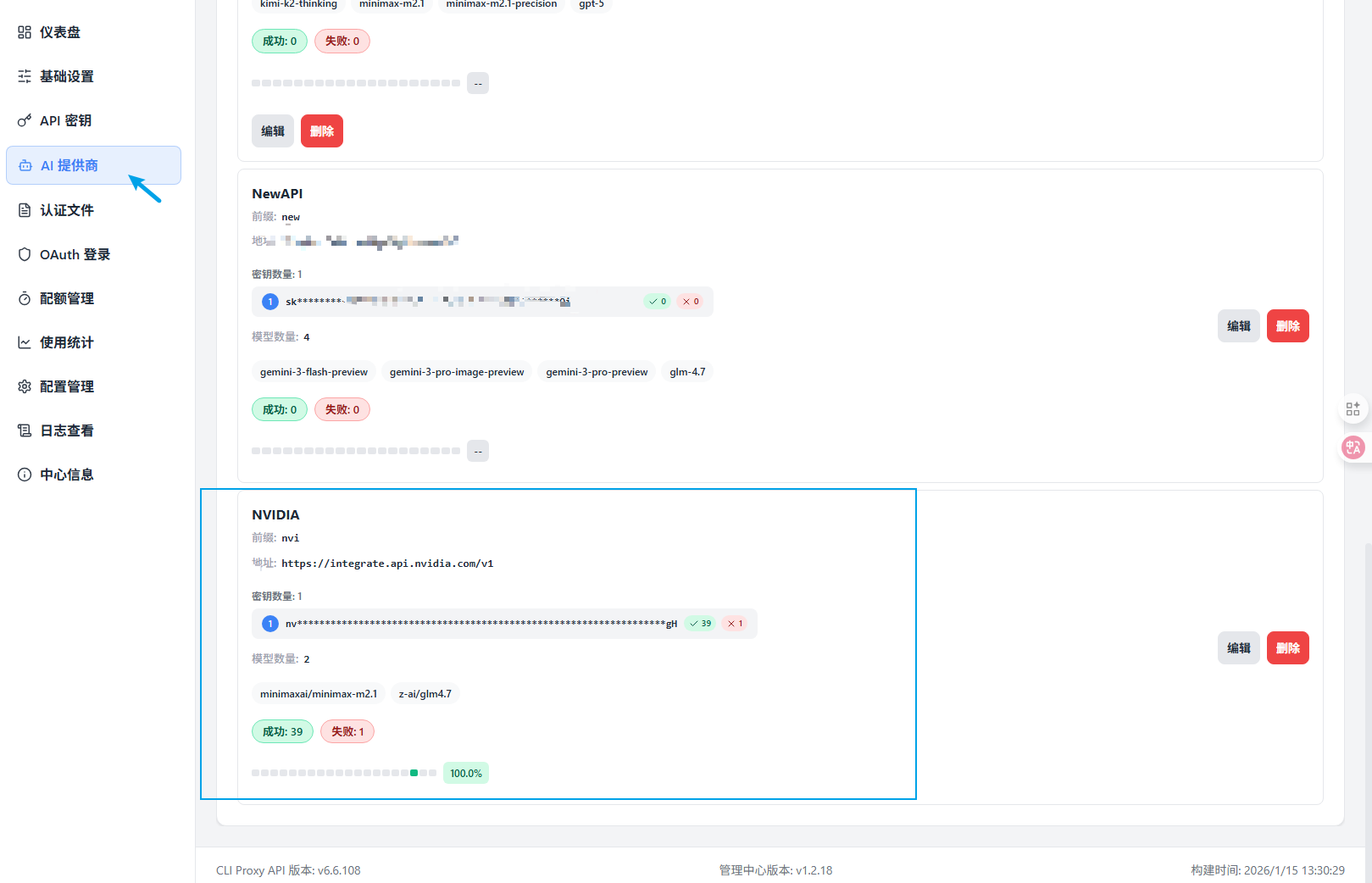

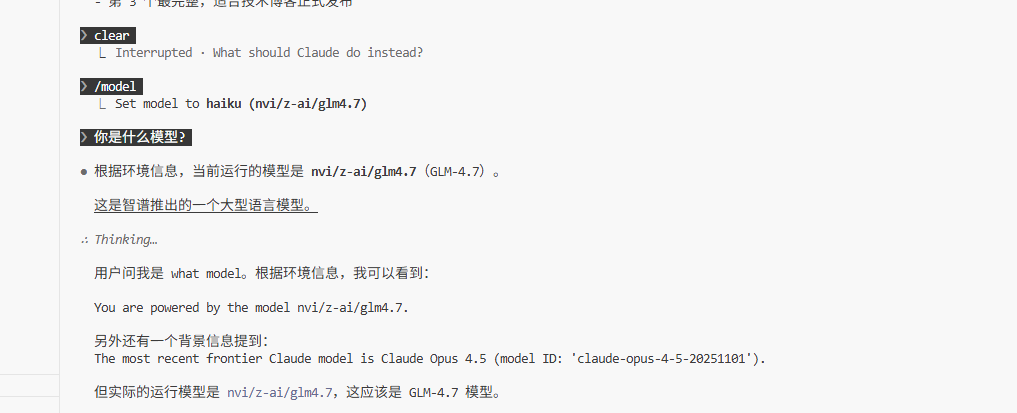

我这里用的是CLIProxyAPI ,只需要在AI提供商里面配置OpenAI兼容提供商,即可使用!

直接将官方地址配置到Claude Code我还没试过,不知道能不能行,因为我主用Claude模型,有兴趣的可以尝试下!

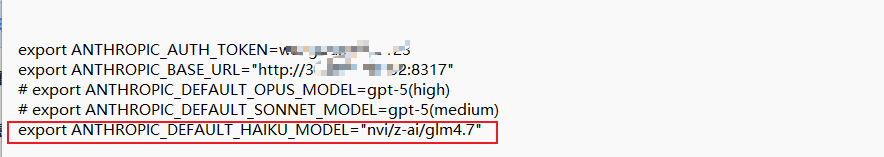

我用的是WSL环境,然后编辑环境变量文件(\root.bashrc)就可以使用了. 其他环境可以问下AI如何修改!

配置稍微复杂一点,但对于需要稳定性和成本控制的场景很有用。

需要飞机吗?

不需要。

NVIDIA NIM 的 API 地址 integrate.api.nvidia.com 在国内可以直接访问!

这可能是目前最省心的免费 API 选择了——不用折腾网络环境,不用担心封号,直接干就完了。

我的使用建议

试用了两天,说说我的体会:

适合用 GLM-4.7 的场景:

- 前端开发,尤其是需要好看 UI 的

- 一次性交付的编程任务

- 需要深度思考的复杂问题

适合用 MiniMax M2.1 的场景:

- 多语言项目(Java、Go、Rust 这些)

- 需要长时间运行的 Agent 任务

- 对响应速度有要求的场景

不太适合的场景:

- 需要图片输入的任务(GLM-4.7 不支持)

- 对延迟极度敏感的实时应用(毕竟是免费的,资源紧张时会变慢)

最后

NVIDIA 这波操作挺有意思的。把国产顶流模型免费开放出来,既是给开发者发福利,也是在推广自家的 NIM 生态。

对于普通用户来说,这就是个白嫖的好机会。GLM-4.7 和 MiniMax M2.1 都是刚发布的新模型,能力确实能打。趁着现在资源还没被挤爆,赶紧去试试。

至于能免费多久,谁也说不准。反正先用着再说。